潮人地東莞seo博客小編下面跟大家分享關于等問題,希望seo專員在做seo優化的過程中有所幫助,內容僅供參考。

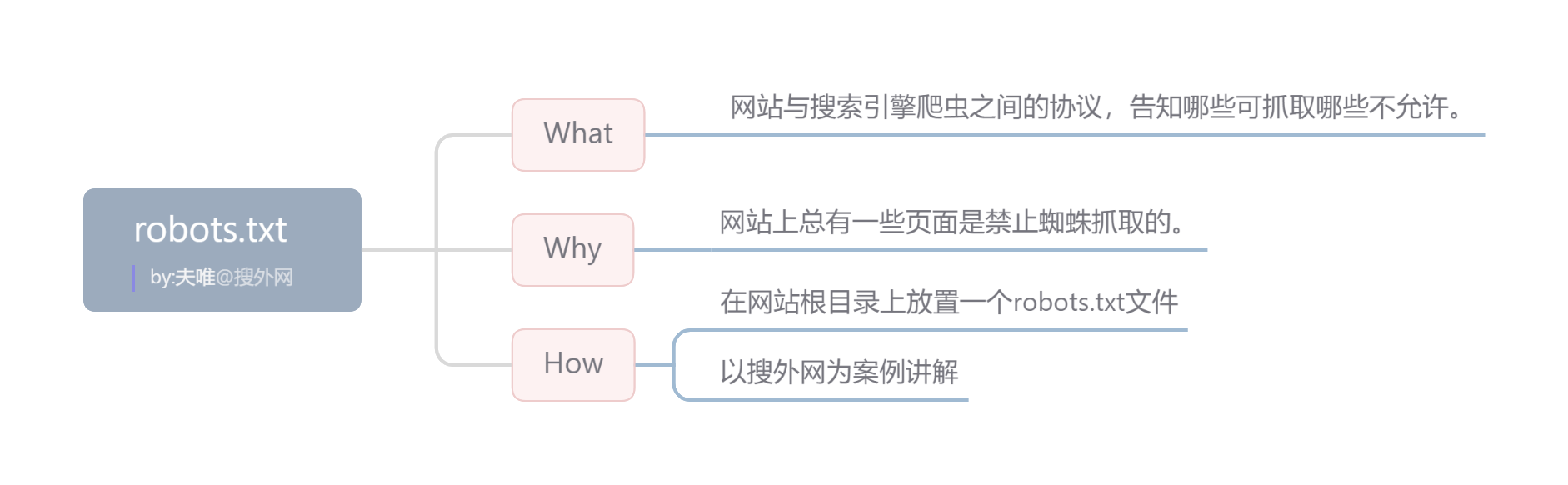

| 什么是robots文件?

Robots是站點與spider溝通的重要渠道,是網站與搜索引擎爬蟲之間的協議,告知哪些可抓取哪些不允許。

seo博客相關推薦閱讀:seo優化博客:網站優化seo是怎樣,為怎樣要學這門技術

?

| 為什么要做robots文件?

網站上總有一些頁面是禁止蜘蛛抓取的。例如:搜索頁面、篩選頁面、后臺登錄地址等。

?

| 如何制作 robots文件?

編吉林完善seo優化方法寫robots.txt文件并上傳到網站根目錄。

?

| 制作 robots.txt注意事項

●?所有搜索引擎則用星號表示

●?Allow(允許)和Disallow(不允許)優先級

●?至少屏蔽一個,可以屏蔽:搜索結果頁面/404頁面

●?記得將sitemap放到Robots文件中

●?可以陸續放入更多,而不是一次性決定所有

●?網站后臺地址/圖片地址/下載文件地址/錯誤鏈接

?

本文的視頻課程地址:https://ke.seowhy.com/play/9492.html

閱讀本文的人還可以閱讀:

什么是robots文件?設置搜索robots協議的后果seo優化常用方法推廣排名

robots.txt文件用法舉例,百度官方資料截圖版

robots.txt概念和10條注意事項

Robots.txt 文件應放在哪里?

如何使用Robots避免蜘蛛黑洞?

以上是潮人地東莞seo博客跟大家分享關于百度seo優化排名:robots.txt:如何讓搜索引擎不要抓取沒用的頁面等問題,希望能對大家有所幫助,若有不足之處,請諒解,我們大家可以一起討論關于網站seo優化排名的技巧,一起學習,以上內容僅供參考。